A escassez de chips da Nvidia deixa as startups de IA correndo atrás de poder de computação

Escassez de chips Nvidia afeta startups de IA.

Por volta das 11h da manhã, horário da costa leste dos Estados Unidos em dias úteis, enquanto a Europa se prepara para encerrar o expediente, a costa leste dos EUA enfrenta a correria do meio do dia e o Vale do Silício se aquece, o gerador de imagens de IA da startup Astria, sediada em Tel Aviv, está tão ocupado quanto sempre. No entanto, a empresa não lucra muito com esse aumento de atividade.

Empresas como a Astria, que estão desenvolvendo tecnologias de IA, usam processadores gráficos (GPUs) para treinar software que aprende padrões em fotos e outros meios de comunicação. Os chips também lidam com a inferência, ou seja, o aproveitamento dessas lições para gerar conteúdo em resposta às solicitações do usuário. Mas a corrida global para integrar a IA em todos os aplicativos e programas, combinada com desafios persistentes na fabricação que remontam ao início da pandemia, tem causado escassez de GPUs.

Essa escassez de oferta significa que nos horários de pico, as GPUs ideais no principal fornecedor de computação em nuvem da Astria (Amazon Web Services), que a startup precisa para gerar imagens para seus clientes, estão com capacidade total, e a empresa precisa usar GPUs mais poderosas e mais caras para concluir o trabalho. Os custos se multiplicam rapidamente. “É como se perguntar, quanto mais você pagará?” diz Alon Burg, fundador da Astria, que brinca que se perguntou se investir em ações da Nvidia, maior fabricante de GPUs do mundo, seria mais lucrativo do que seguir com sua startup. A Astria cobra seus clientes de uma forma que equilibra esses picos caros, mas ainda está gastando mais do que o desejado. “Eu adoraria reduzir os custos e contratar mais alguns engenheiros”, diz Burg.

Não há um fim imediato à vista para a escassez de GPUs. A líder de mercado, Nvidia, que representa cerca de 60 a 70 por cento do fornecimento global de chips de servidor de IA, anunciou ontem que vendeu um recorde de US$ 10,3 bilhões em GPUs para centros de dados no segundo trimestre, um aumento de 171 por cento em relação ao ano anterior, e que as vendas devem superar as expectativas novamente no trimestre atual. “Nossa demanda é enorme”, disse o CEO Jensen Huang a analistas em uma teleconferência de resultados. Os gastos globais com chips focados em IA devem atingir US$ 53 bilhões este ano e mais que dobrar nos próximos quatro anos, segundo a empresa de pesquisa de mercado Gartner.

A escassez contínua significa que as empresas estão tendo que inovar para manter acesso aos recursos de que precisam. Algumas estão juntando dinheiro para garantir que não deixarão os usuários na mão. Em todos os lugares, termos de engenharia como “otimização” e “tamanho de modelo menor” estão na moda, à medida que as empresas tentam reduzir suas necessidades de GPU, e investidores neste ano apostaram centenas de milhões de dólares em startups cujo software ajuda as empresas a se virarem com as GPUs que têm. Uma dessas startups, a Modular, recebeu consultas de mais de 30.000 clientes em potencial desde o lançamento em maio, segundo seu cofundador e presidente, Tim Davis. A habilidade de navegar pela escassez no próximo ano pode se tornar um determinante de sobrevivência na economia de IA generativa.

- O Walmart irá entregar ovos e sorvete por drone para alguns texanos

- 5 Melhores Softwares de Gestão de Inventário na Índia para PMEs

- Os melhores serviços de proteção contra roubo de identidade e monit...

“Vivemos em um mundo com capacidade limitada, onde temos que usar a criatividade para juntar as coisas, misturar as coisas e equilibrar as coisas”, diz Ben Van Roo, CEO do Yurts, um auxiliar de escrita de negócios baseado em IA. “Eu me recuso a gastar muito dinheiro em computação.”

Os provedores de computação em nuvem estão cientes de que seus clientes estão lutando por capacidade. A demanda crescente pegou a indústria de surpresa”, diz Chetan Kapoor, diretor de gerenciamento de produtos da AWS.

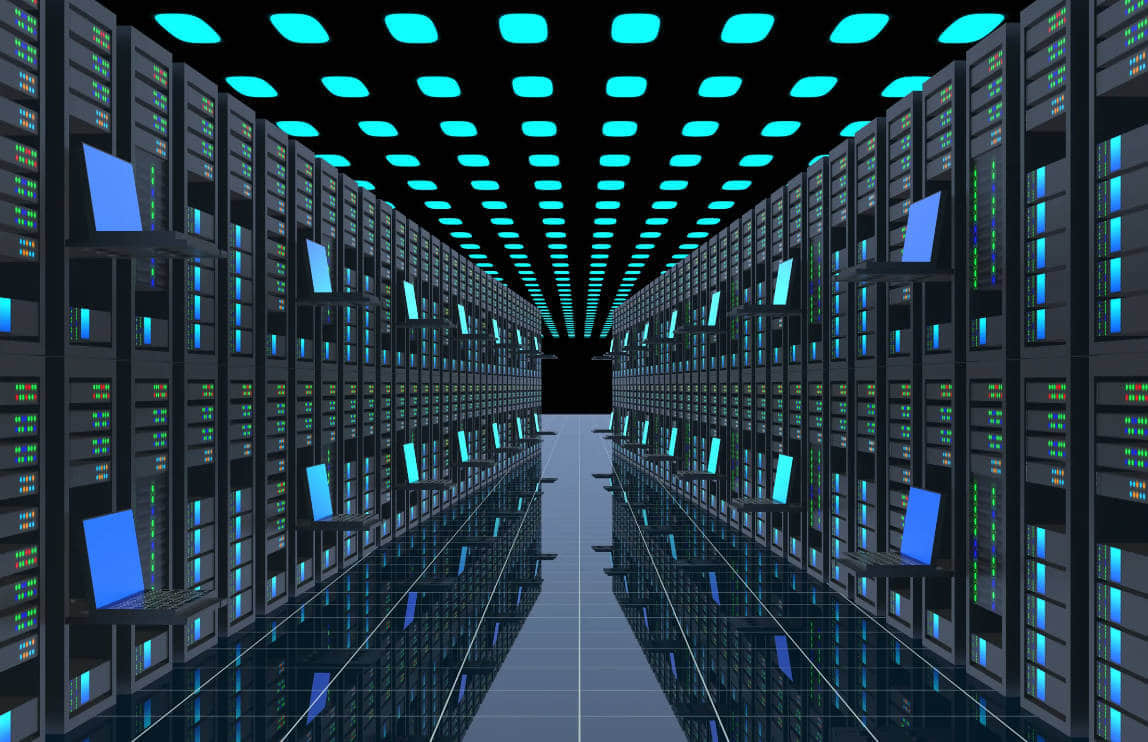

O tempo necessário para adquirir e instalar novas GPUs em seus data centers tem deixado as gigantes da nuvem para trás, e os arranjos específicos mais procurados também causam estresse. Enquanto a maioria dos aplicativos pode operar com processadores distribuídos de forma dispersa pelo mundo, o treinamento de programas de IA generativa tende a funcionar melhor quando as GPUs estão fisicamente agrupadas, às vezes 10.000 chips de cada vez. Isso amarra a disponibilidade como nunca antes.

Kapoor diz que o cliente típico de IA generativa da AWS está acessando centenas de GPUs. “Se um cliente específico solicitar 1.000 GPUs para amanhã, levará algum tempo para encaixá-los”, diz Kapoor. “Mas se eles forem flexíveis, podemos resolver isso.”

A AWS sugeriu que os clientes adotem serviços mais caros e personalizados por meio de sua oferta Bedrock, onde as necessidades de chips são incorporadas à oferta sem que os clientes precisem se preocupar. Ou os clientes podem experimentar os chips de IA exclusivos da AWS, Trainium e Inferentia, que registraram um aumento não especificado na adoção, segundo Kapoor. Adaptar programas para operar nesses chips em vez das opções da Nvidia costumava ser uma tarefa árdua, mas Kapoor diz que a mudança para o Trainium agora requer apenas a alteração de duas linhas de código de software em alguns casos.

Desafios também surgem em outros lugares. A Google Cloud não tem conseguido acompanhar a demanda por seu equivalente a GPU desenvolvido internamente, conhecido como TPU, segundo um funcionário não autorizado a falar com a mídia. Um porta-voz não respondeu a um pedido de comentário. A unidade de nuvem Azure da Microsoft ofereceu reembolsos a clientes que não estão usando as GPUs que reservaram, informou o Information em abril. A Microsoft se recusou a comentar.

As empresas de nuvem preferem que os clientes reservem capacidade com meses a anos de antecedência, para que esses provedores possam planejar melhor suas próprias compras e instalações de GPU. Mas as startups, que geralmente têm dinheiro mínimo e necessidades intermitentes enquanto resolvem seus produtos, têm relutado em se comprometer, preferindo planos de compra conforme o uso. Isso levou a um aumento nos negócios para provedores de nuvem alternativos, como Lambda Labs e CoreWeave, que juntos atraíram quase US $ 500 milhões de investidores este ano. A Astria, a startup de geração de imagens, está entre seus clientes.

A AWS não está exatamente feliz por perder espaço para novos participantes do mercado, por isso está considerando opções adicionais. “Estamos pensando em diferentes soluções a curto e longo prazo para fornecer a experiência que nossos clientes estão procurando”, diz Kapoor, recusando-se a comentar mais detalhes.

A falta de recursos nos fornecedores de nuvem está afetando seus clientes, que incluem nomes importantes do setor de tecnologia. A plataforma de mídia social Pinterest está expandindo o uso de IA para melhor atender aos usuários e anunciantes, de acordo com o diretor de tecnologia Jeremy King. A empresa está considerando o uso dos novos chips da Amazon. “Precisamos de mais GPUs, como todos”, diz King. “A escassez de chips é uma coisa real.”

A OpenAI, que desenvolve o ChatGPT e licencia a tecnologia subjacente para outras empresas, depende muito de chips da Azure para fornecer seus serviços. A escassez de GPUs obrigou a OpenAI a estabelecer limites de uso nas ferramentas que vende. Isso tem sido desfavorável para os clientes, como a empresa por trás do assistente de IA Jamie, que resume áudio de reuniões usando a tecnologia da OpenAI. Jamie adiou os planos de lançamento público em pelo menos cinco meses, em parte porque queria aperfeiçoar seu sistema, mas também por causa dos limites de uso, diz Louis Morgner, cofundador da startup. O problema não diminuiu. “Estamos a apenas algumas semanas de ir a público e precisaremos monitorar de perto como nosso sistema pode dimensionar bem, dadas as limitações de nossos provedores de serviços”, diz Morgner.

“A indústria está enfrentando uma forte demanda por GPUs”, diz o porta-voz da OpenAI, Niko Felix. “Continuamos trabalhando para garantir que os clientes de nossa API tenham a capacidade de atender às suas necessidades”.

Neste momento, qualquer conexão que possa dar a uma startup acesso a poder de computação é vital. Investidores, amigos, vizinhos – os executivos de startups estão recorrendo a uma variedade de relacionamentos para obter mais poder de IA. A Astria, por exemplo, conseguiu capacidade adicional na AWS com a ajuda de Emad Mostaque, CEO da Stability AI, que é um parceiro próximo da AWS e cuja tecnologia a Astria utiliza.

A startup de contabilidade Pilot, que usa a tecnologia da OpenAI para classificar alguns dados mundanos, obteve acesso antecipado ao GPT-4 depois de solicitar ajuda de amigos universitários, funcionários e capitalistas de risco com conexões na OpenAI. Se essas conexões aceleraram a saída da lista de espera do Pilot não está claro, mas agora ele gasta cerca de US $ 1.000 por mês na OpenAI, e essas conexões podem ser úteis quando ele precisar aumentar sua cota, diz o CEO Waseem Daher. “Se você não aproveitar essa tecnologia geradora de IA, outra pessoa o fará, e ela é poderosa o suficiente para você não querer correr esse risco”, diz Daher. “Você quer entregar os melhores resultados para seus clientes e estar por dentro do que está acontecendo na indústria”.

Além de lutar para obter acesso a mais poder, as empresas estão tentando fazer mais com menos. Empresas que experimentam IA generativa agora estão obcecadas com a “otimização” – tornar o processamento, com resultados satisfatórios, possível nas GPUs mais acessíveis. Isso é análogo a economizar dinheiro abandonando uma geladeira antiga e que consome muita energia que está apenas armazenando algumas bebidas por uma minigeladeira moderna que pode funcionar com energia solar na maior parte do tempo.

As empresas estão tentando escrever instruções melhores sobre como os chips devem processar instruções de programação, tentando reformatar e limitar a quantidade de dados usados para treinar os sistemas de IA e, em seguida, reduzir o código de inferência ao mínimo necessário para lidar com a tarefa em questão. Isso significa criar vários sistemas menores – talvez um gerador de imagens que produza animais e outro que crie imagens de humanos – e alternar entre eles, dependendo da solicitação do usuário.

Também estão agendando processos que não são sensíveis ao tempo para serem executados quando a disponibilidade de GPU é maior e fazendo compromissos para equilibrar velocidade e acessibilidade.

A startup Resemble AI, que gera fala, está satisfeita em levar um décimo de segundo a mais para processar uma solicitação do cliente em um chip mais antigo, se isso significar gastar um décimo do que opções de ponta exigiriam, sem diferença perceptível na qualidade do áudio, diz o CEO Zohaib Ahmed. Ele também está disposto a buscar alternativas à Lambda e CoreWeave, caso as condições se tornem menos favoráveis – com incentivos para fazer compromissos de longo prazo. A CoreWeave se recusou a comentar e a Lambda não respondeu a um pedido de comentário.

Resemble recorreu à FluidStack, um pequeno provedor que aceita reservas de GPU por uma semana ou um mês, e recentemente se juntou ao San Francisco Compute Group, um consórcio de startups que se comprometem coletivamente a comprar e compartilhar capacidade de GPU. “O ecossistema de startups está tentando se unir e descobrir ‘Como lutamos, como lutamos pelo poder de processamento?’ Caso contrário, seria um jogo muito injusto. Os preços estão simplesmente muito altos”, diz Ahmed.

Ele tem um vislumbre de esperança em relação às escassezes todas as manhãs de segunda-feira, diz ele. Um representante de vendas da Lambda, o provedor de nuvem, tem escrito para ele, perguntando se a Resemble deseja reservar algum dos mais novos chips da Nvidia, o H100. O fato de haver disponibilidade é empolgante, diz Ahmed, mas esses chips só estão amplamente disponíveis desde março, e é apenas uma questão de tempo antes que as empresas que estão testando eles aperfeiçoem o código para usá-los em sua totalidade. A Nvidia lançará seu mais recente e melhor, a segunda geração GH200, no próximo ano. Então o ciclo de escassez começará novamente.