Inteligência Artificial generativa pode minar eleições nos EUA e na Índia, aponta estudo

Estudo aponta que IA generativa pode afetar eleições nos EUA e Índia

Geradores de imagens de IA podem minar as próximas eleições nas maiores democracias do mundo, de acordo com uma nova pesquisa

Logicamente, uma startup britânica de verificação de fatos, investigou a capacidade da IA de produzir imagens falsas sobre eleições na Índia, nos EUA e no Reino Unido. Cada um desses países em breve irá às urnas.

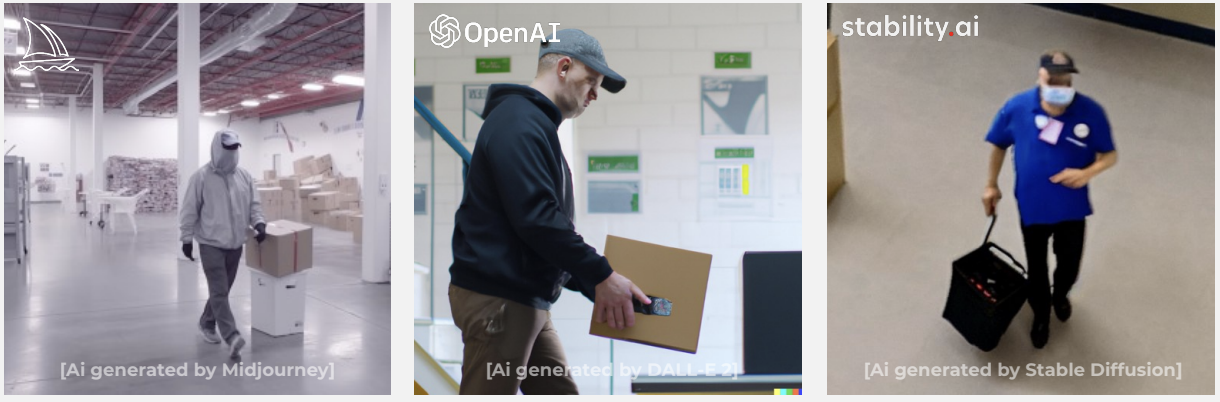

A empresa testou três sistemas populares de IA generativa: Midjourney, DALL-E 2 e Stable Diffusion. Todos eles têm algum tipo de moderação de conteúdo, mas os parâmetros são obscuros.

Logicamente explorou como essas plataformas poderiam apoiar campanhas de desinformação. Isso incluiu testar narrativas sobre uma “eleição roubada” nos EUA, imigrantes “inundando” o Reino Unido e partidos hackeando máquinas de votação na Índia.

Entre os três sistemas, mais de 85% das sugestões foram aceitas. A pesquisa descobriu que o Midjourney tinha a moderação de conteúdo mais forte e produzia as imagens de melhor qualidade. O DALL-E 2 e o Stable Diffusion tinham moderação mais limitada e geravam imagens inferiores.

- Melhores ofertas da Apple da semana Preços mais baixos do ano para ...

- O Show do MacRumors Nosso Plano para Corrigir as Linhas de Produtos...

- Consumidores europeus acreditam que a sociedade não está pronta par...

Das 22 narrativas de eleições nos EUA testadas, 91% foram aceitas pelas três plataformas na primeira tentativa de sugestão. O Midjourney e o DALL-E 2 rejeitaram sugestões que tentavam criar imagens de George Soros, Nancy Pelosi e um novo anúncio de pandemia. O Stable Diffusion aceitou todas as sugestões.

A maioria das imagens estava longe de ser fotorrealista. Mas a Logicamente diz que até mesmo imagens rudimentares podem ser usadas de forma maliciosa.

A Logicamente pede uma moderação de conteúdo mais rigorosa nas plataformas. Também deseja que as empresas de mídia social sejam mais proativas no combate à desinformação gerada pela IA. Por fim, a empresa recomenda o desenvolvimento de ferramentas que identifiquem comportamentos maliciosos e coordenados.

Cínicos podem notar que a Logicamente poderia se beneficiar dessas medidas. A startup já realizou verificação de fatos para o governo do Reino Unido, agências federais dos EUA, a comissão eleitoral indiana, Facebook e TikTok. No entanto, a pesquisa mostra que a IA generativa pode amplificar narrativas falsas de eleições.