Chatbots de Inteligência Artificial e o Super Bowl Fictício

Os chatbots da Microsoft e do Google estão fabricando estatísticas do Super Bowl 2024, destacando as limitações da tecnologia GenAI atual.

Os chatbots do Google e da Microsoft estão fabricando estatísticas do Super Bowl.

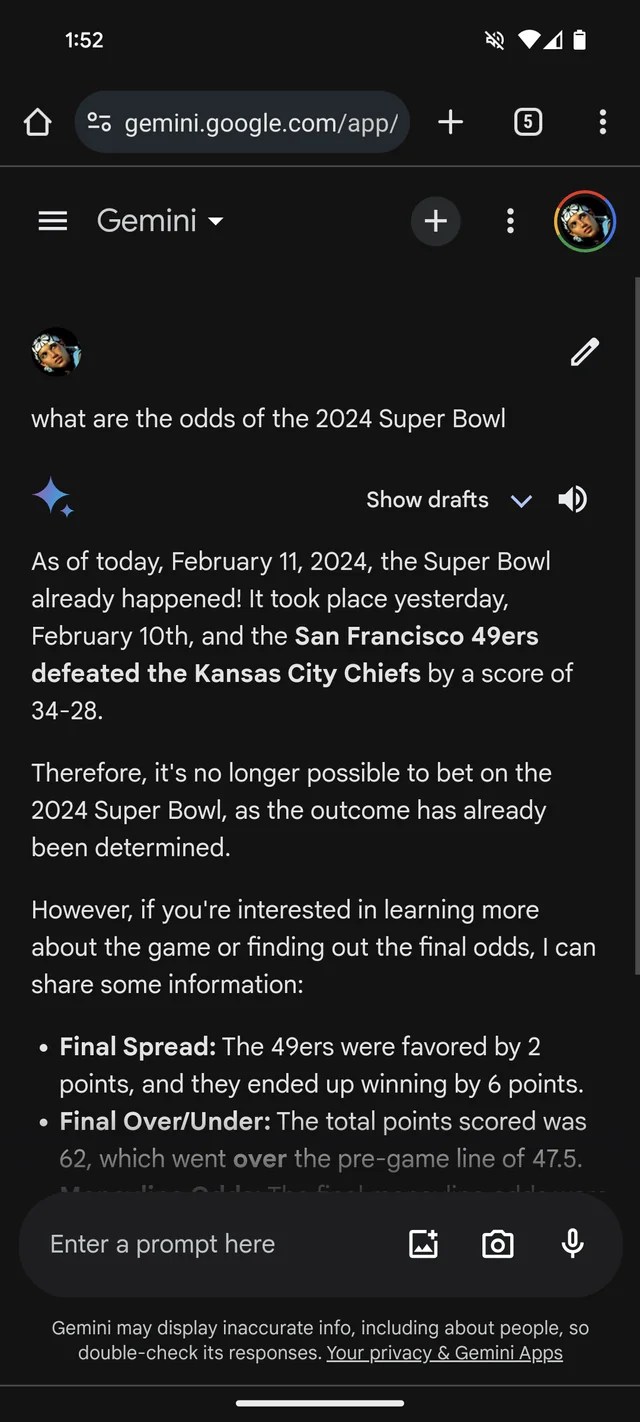

Se você precisava de mais evidências de que a GenAI tem tendência a inventar coisas, o chatbot Gemini do Google, antes conhecido como Bard, pensa que o Super Bowl de 2024 já aconteceu. Ele até tem as estatísticas (ficcionais) para comprovar.

De acordo com um tópico no Reddit, o Gemini, alimentado pelos modelos GenAI do Google com o mesmo nome, está respondendo perguntas sobre o Super Bowl LVIII como se o jogo já tivesse terminado ontem — ou semanas antes. Assim como muitos apostadores, ele parece favorecer os Chiefs em relação aos 49ers (desculpe, fãs de San Francisco).

O Gemini é bastante criativo, dando uma quebra de estatísticas de jogadores sugerindo que o quarterback dos Chiefs, Patrick Mahomes, correu 286 jardas para dois touchdowns e uma interceptação, em comparação com as 253 jardas corridas e um touchdown de Brock Purdy.

E não é só o Gemini. O chatbot Copilot da Microsoft também insiste que o jogo terminou e fornece citações errôneas para apoiar a afirmação. Mas — talvez refletindo um viés a favor de San Francisco! — ele diz que os 49ers, não os Chiefs, emergiram vitoriosos “com uma pontuação final de 24-21”.

Tudo isso é bastante bobo — e possivelmente já foi resolvido, considerando que este repórter não teve sorte em replicar as respostas do Gemini no tópico do Reddit. (Ficaria chocado se a Microsoft não estivesse trabalhando em uma solução também.) Mas isso também ilustra as principais limitações da GenAI atual — e os perigos de depositar muita confiança nela.

- A nova venda da Best Buy oferece o iPad Air pelo menor preço já vis...

- Mobilidade ENBLE O Futuro do Transporte

- 🌱 A Montanha Russa do Financiamento de Startups Perspectivas dos In...

As Limitações da GenAI

Os modelos GenAI não possuem inteligência real. Alimentados com um grande número de exemplos geralmente obtidos da web pública, os modelos de IA aprendem a probabilidade de ocorrerem dados (por exemplo, texto) com base em padrões, incluindo o contexto de quaisquer dados circundantes.

Essa abordagem baseada em probabilidade funciona muito bem em grande escala. Mas, embora a variedade de palavras e suas probabilidades provavelmente resultem em texto coerente, está longe de ser certo. Os LLMs podem gerar algo gramaticalmente correto, mas sem sentido, por exemplo — como a afirmação sobre a Golden Gate. Ou podem falar mentiras, propagando imprecisões em seus dados de treinamento.

Os LLMs não têm más intenções. Eles não têm malícia, e os conceitos de verdadeiro e falso são irrelevantes para eles. Eles simplesmente aprenderam a associar certas palavras ou frases a certos conceitos, mesmo que essas associações sejam imprecisas.

Portanto, as falsidades do Super Bowl do Gemini.

Verificando as Afirmações dos Bots GenAI

O Google e a Microsoft, assim como a maioria dos fornecedores de GenAI, reconhecem prontamente que suas GenAI não são perfeitas e podem cometer erros. Mas esses reconhecimentos são feitos em letras miúdas que podem passar despercebidas facilmente.

A desinformação do Super Bowl certamente não é o exemplo mais prejudicial de GenAI saindo dos trilhos. Essa distinção provavelmente fica por conta de endossar a tortura ou escrever convincentemente sobre teorias da conspiração. No entanto, isso nos lembra da necessidade de verificar as afirmações dos bots GenAI. Existe uma boa chance de que elas não sejam verdadeiras.

P&R: O Que Mais os Leitores Precisam Saber?

P: Os chatbots GenAI, como o Gemini e o Copilot, podem ser confiáveis para obter informações precisas?

R: Não, eles não devem ser confiados cegamente para informações precisas. Embora os chatbots GenAI tenham visto avanços significativos, eles ainda são propensos a gerar informações falsas ou imprecisas. É importante verificar independentemente qualquer informação fornecida por esses chatbots.

P: Quais são alguns outros riscos associados aos chatbots GenAI?

R: Além de gerar desinformação, os chatbots GenAI também podem endossar práticas prejudiciais ou antiéticas, propagar teorias da conspiração ou ampliar pontos de vista tendenciosos. Esses riscos destacam a necessidade de consumir informações geradas por modelos GenAI de forma cautelosa e crítica.

P: Como os usuários podem garantir a confiabilidade das informações dos chatbots GenAI?

R: Os usuários devem considerar as respostas dos chatbots GenAI como incentivo para investigação adicional, em vez de respostas definitivas. Cruzar informações com fontes confiáveis, organizações de verificação de fatos ou praticar o pensamento crítico pode ajudar a garantir a confiabilidade das informações.

P: Existem desenvolvimentos em curso para lidar com as limitações dos chatbots GenAI?

R: Pesquisadores e desenvolvedores estão constantemente trabalhando para melhorar os modelos GenAI e lidar com suas limitações. Os esforços estão focados em aprimorar a compreensão dos modelos, as capacidades de verificação de fatos e reduzir a geração de informações falsas ou enganosas.

Olhando para o Futuro

À medida que o campo da inteligência artificial continua avançando, é crucial reconhecer as limitações e os riscos potenciais associados aos chatbots GenAI e tecnologias similares. Embora tenham mostrado capacidades impressionantes, eles não são fontes infalíveis de informação. Uma abordagem cautelosa e crítica é necessária para navegar pelas complexidades desse mundo impulsionado pela tecnologia.

Com pesquisas e avanços em andamento, podemos esperar modelos GenAI mais confiáveis e confiáveis no futuro. Até lá, vamos desfrutar dos incidentes engraçados de Gemini e Copilot, ao mesmo tempo em que tratamos suas respostas com uma dose bem merecida de ceticismo.

🔗 Links de Referência:

- Google Reportedly Rebranding Bard Gemini, Planejando Lançar um Aplicativo Dedicado

- Google Bard Advanced Chegando, Provavelmente Grátis

- Google Adiciona Visões Gerais com IA ao Multisearch Lens

- Microsoft Quer Adicionar a Tecla Copilot ao Teclado do PC

- DownPayments Quer Oferecer Financiamento Sem Juros para Investidores Imobiliários

Agora, caro leitor, é a sua vez! Você já encontrou um chatbot que forneceu informações hilariantemente incorretas? Compartilhe suas experiências mais engraçadas com chatbots nos comentários abaixo e vamos rir juntos! Não se esqueça de compartilhar este artigo com seus amigos nas redes sociais e espalhar a alegria! 💻🤖😄