A IA generativa irá ultrapassar em muito o que o ChatGPT pode fazer. Aqui está tudo sobre como a tecnologia avança

IA generativa ultrapassará ChatGPT. Tecnologia avança.

Mais do que qualquer uma das muitas conquistas em inteligência artificial – ganhar no xadrez, prever a dobragem de proteínas, rotular gatos e cachorros – a forma de IA conhecida como IA generativa tem cativado a imaginação global.

O ChatGPT tornou-se o programa de software de crescimento mais rápido da história em janeiro, atingindo cem milhões de usuários em menos de dois meses desde sua estreia pública. Ele gerou inúmeros concorrentes, tanto programas proprietários como o Bard do Google, quanto alternativas de código aberto como o Koala da Universidade da Califórnia em Berkeley. A onda de empolgação tem provocado uma corrida armamentista entre gigantes da tecnologia como Microsoft e Google e seus pares, e um aumento nos negócios do fabricante de chips de IA Nvidia.

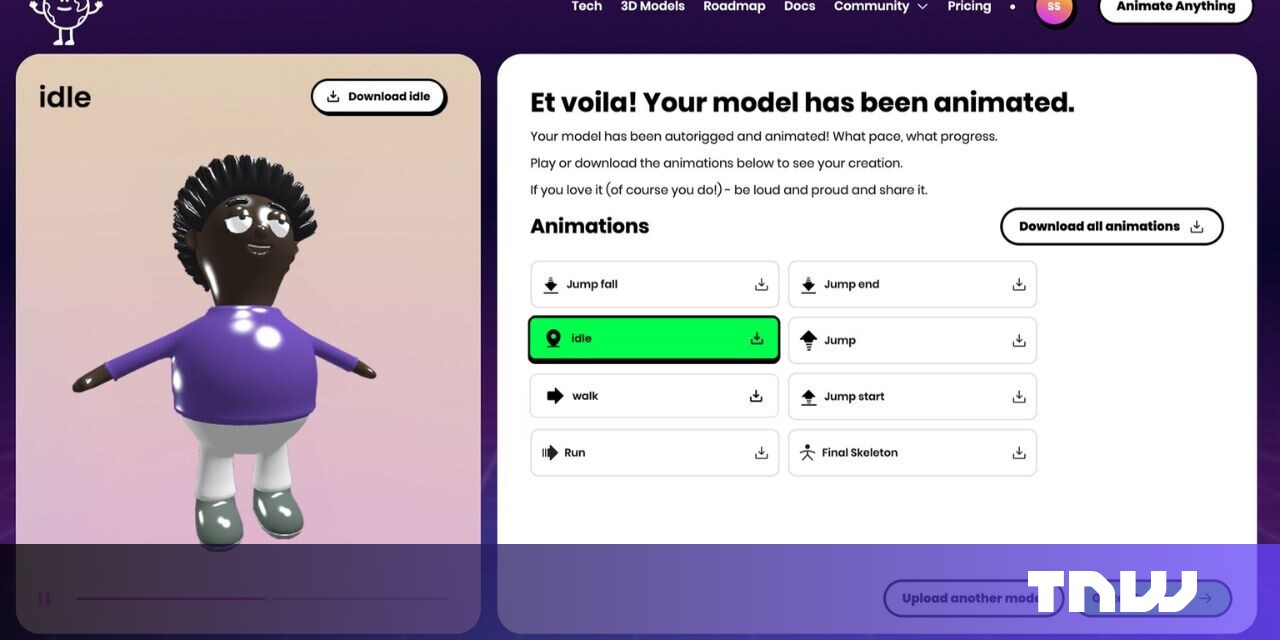

A empolgação com os grandes modelos de linguagem tem levado ao florescimento de inúmeros programas proprietários e de código aberto de escala cada vez maior apenas para texto. O diagrama é do artigo de 2023 “Inteligência Emocional de Grandes Modelos de Linguagem” de Xuena Wang e colegas da Universidade Tsinghua.

Toda essa atividade fervorosa tem suas raízes no simples fato de que, ao contrário dos programas de IA do passado, que na maioria das vezes produziam uma pontuação numérica – um “1” para uma foto de gato, um “0” para uma foto de cachorro – o ChatGPT e programas de imagem como o Stable Diffusion da Stability.ai e o DALL-E da OpenAI reproduzem algo do mundo.

Recursos Especiais

- Apple Pencil 3 pode apresentar pontas magnéticas para diferentes es...

- A Apple começa a vender o HomePod recondicionado de 2023 em países ...

- O Apple Watch original agora é obsoleto, incluindo o modelo de ouro...

O Surgimento da IA Generativa

Uma nova onda de ferramentas de IA tem surpreendido o mundo e nos dado uma visão de uma nova forma de trabalhar e encontrar informações que podem otimizar nosso trabalho e nossas vidas. Mostramos as maneiras como ferramentas como o ChatGPT e outros softwares de IA geracional estão causando impacto no mundo, como aproveitar seu poder, bem como os riscos potenciais.

Ao produzir um parágrafo, uma imagem, ou até mesmo o esqueleto de um programa de computador, tais programas estão espelhando as criações da sociedade.

O aspecto de espelhamento vai aumentar dramaticamente em um curto espaço de tempo.

Os programas generativos de hoje parecerão primitivos em comparação com os poderes dos programas que estarão em evidência no final deste ano, à medida que eles produzem muitos mais tipos de coisas.

Migrando para múltiplas modalidades

O que os cientistas da computação chamam de modalidades mistas, ou “multi-modalidade”, ocupará o centro do palco, à medida que os programas fundem texto, imagens, “nuvens de pontos” do espaço físico, sons, vídeo e funções inteiras de computador como aplicativos inteligentes.

A modalidade mista possibilitará programas muito mais capazes e contribuirá para um objetivo de aprendizado contínuo há muito tempo almejado. Ela pode até mesmo impulsionar o objetivo de “IA incorporada” ao dar um impulso à robótica.

“O ChatGPT foi feito para entretenimento, e ele faz muitas coisas muito bem, mas é meio que uma demonstração”, disse Naveen Rao, fundador da startup de IA MosaicML, em uma entrevista com a ENBLE. “Agora precisamos começar a pensar sobre como podemos melhorar isso, se estou usando para algum propósito.”

Rao, cuja empresa foi adquirida pela Databricks por sua expertise em execução de programas de IA, agora atua como vice-presidente de IA generativa na Databricks.

Também: O gerador de imagens de IA do Meta diz que talvez a linguagem seja tudo o que você precisa

Parte dessa melhoria será tornar a IA generativa mais do que apenas um “Copiloto” pessoal, como o GitHub Copilot da Microsoft, que auxilia um único indivíduo digitando em um prompt de chat. Os programas se tornarão colaborativos, para equipes, disse Emad Mostaque, fundador e CEO da Stability.ai, em uma entrevista com a ENBLE.

“Muita IA é usada apenas como algo de um-para-um, ou é um agente autônomo”, disse Mostaque. “Agora estamos na fase do iPhone 2G, em que é apenas um modo único e você copia e cola, enquanto acredito que a coisa mais empolgante é como podemos colaborar melhor e contar histórias melhores com ela, e isso não é um empreendimento solitário.”

Uma das coisas que está “fundamentalmente faltando”, disse Rao, da Databricks, “é a multi-modalidade do mundo”, considerando que “grandes modelos de linguagem são muito unidimensionais, pois eles só veem o mundo através do texto.”

Modalidades se referem à natureza da entrada e da saída, como texto, imagem ou vídeo. Uma variedade de modalidades é possível e tem sido explorada com crescente diversidade, porque os mesmos conceitos básicos que impulsionam o ChatGPT podem ser aplicados a qualquer tipo de entrada.

“A multi-modalidade é o caminho, com certeza”, disse Mostaque. “Você precisará de modelos de cada tipo, e talvez, se você os unir, será incrível.”

“As coisas somente relacionadas à linguagem ganharam muita visibilidade e empolgação, e, portanto, a mídia foca nisso, mas as pessoas estão trabalhando seriamente em outras coisas”, disse Jim Keller, um renomado designer de chips de computador que é CEO da startup de chips de IA Tenstorrent, em uma entrevista com a ENBLE. Keller está apostando em sua empresa na perspectiva de que lidar com modalidades mistas será uma das grandes demandas de IA no futuro.

Uma máquina para qualquer tipo de dado

Em um grande modelo de linguagem, que é o coração da tecnologia do ChatGPT, o texto é convertido em um token, uma representação matemática quantificada. A máquina então precisa encontrar o que está faltando em partes ocultas de uma frase inteira ou na última parte de uma frase. É o ato de recriação que gera os parágrafos que o ChatGPT produz.

Da mesma forma, no caso de imagens, o processo de difusão amplamente utilizado – popularizado pela versão Stable Diffusion da Stability.ai – corrompe as imagens com ruído, e o ato de recriar a imagem original treina uma rede neural para gerar imagens de alta fidelidade.

Também: A IA generativa pode resolver o maior problema não resolvido da ciência da computação?

Os mesmos processos de recuperar o que está faltando ou corrompido estão se espalhando rapidamente para várias modalidades, ou seja, tipos de dados. Por exemplo, em um recente artigo da revista Nature, o biólogo David Baker e sua equipe da Universidade de Washington corromperam as sequências de aminoácidos de proteínas por meio de um processo chamado RFdiffusion. Esse processo treinará uma rede neural para produzir uma proteína, em simulação, uma proteína sintética nova, que possui propriedades desejadas.

Essa síntese pode reduzir drasticamente o número de proteínas que precisam ser inventadas e testadas para encontrar novos anticorpos para doenças. (O artigo da Nature está protegido por um paywall, mas uma versão gratuita está disponível no servidor de arquivos bioRxiv. Mais informações podem ser encontradas no site do Laboratório Baker.)

O processo RFdiffusion desenvolvido pelo Laboratório Baker do Instituto de Design de Proteínas da Universidade de Washington corrompe sequências de aminoácidos para então sintetizar uma estrutura de proteína nova, da mesma forma que a difusão de imagens cria imagens.

“Temos laboratórios para cada modalidade”, disse Mostaque, da Stability.ai, que afirma que sua empresa e a OpenAI são “as únicas duas empresas independentes multi-modais”, fora dos gigantes da tecnologia como o Google. Essa multi-modalidade inclui um laboratório na Stability.ai apenas para áudio, ele disse, um laboratório apenas para geração de código, até um laboratório para biologia que trabalha em coisas como a recriação de imagens de fMRI usando a tecnologia Stable Diffusion.

No entanto, a mágica acontece quando mais modalidades são combinadas. A “descoberta”, disse Mostaque, ocorreu no trabalho do ano passado de Katherine Crowson e vários outros pesquisadores que treinaram uma rede neural geradora de imagens para continuar refinando sua saída até que a saída atendesse a uma solicitação baseada em texto. Eles descobriram que retrabalhar as imagens para corresponder ao conteúdo “semântico” do texto melhorava a qualidade das imagens. Crowson agora está na Stability.ai, observou Mostaque.

Esse trabalho de imagem-texto tem progredido rapidamente em diversas instituições. Os pesquisadores de IA da Meta propuseram uma combinação de máquinas de texto e imagem chamada CM3Leon, que se destaca não apenas na geração de texto ou na geração de imagens, mas na realização de tarefas que envolvem ambos ao mesmo tempo, como identificar objetos em uma determinada imagem ou gerar legendas a partir de uma determinada imagem.

A rede neural CM3Leon da Meta combina imagens e texto para realizar várias tarefas, como descrever detalhadamente uma determinada imagem ou alterar uma determinada imagem com precisão. Isso é detalhado no artigo de 2023, “Scaling Autoregressive Multi-Modal Models: Pre-training and Instruction Tuning”, de Lilu Yu e colegas da Meta AI.

Uma imagem mais completa do mundo

A combinação de múltiplas modalidades começa a construir uma imagem mais completa do mundo para a rede neural. Rao, da Databricks, cita o conceito de neurociência chamado “estereognose”, que significa conhecer o mundo pelo sentido do tato. Se alguém perguntar quanto dinheiro você tem no bolso, você pode sentir as moedas e dizer pelo tamanho e peso sem vê-las. “Eu tenho uma representação do mundo e dos objetos que são representados em múltiplas modalidades”, disse ele. “Se eu puder aprender conceitos que abrangem modalidades diferentes, então fizemos algo interessante”.

A ideia de que diferentes sentidos contribuem para a compreensão é refletida nos experimentos multimodais em andamento. A pesquisa está ativa em como criar redes neurais “backbone” que possam combinar uma ampla variedade de modalidades, e eles mostram benefícios de desempenho intrigantes.

Recentemente, estudiosos da Universidade Carnegie Mellon apresentaram o que eles chamam de “Transformador Multimodal de Alta Modalidade”, que combina não apenas texto, imagem, vídeo e fala, mas também informações de tabelas de banco de dados e dados de séries temporais. O autor principal, Paul Pu Liang, e seus colegas relataram que observaram “um comportamento crucial de escalonamento” da rede neural de 10 modalidades. “O desempenho continua a melhorar com cada modalidade adicionada e se transfere para modalidades e tarefas totalmente novas”.

O artigo de 2023 da Universidade Carnegie Mellon “Transformador Multimodal de Alta Modalidade”, de Paul Liang e colegas, combina não apenas texto, imagem, vídeo e fala, mas também informações de tabelas de banco de dados e dados de séries temporais.

Os estudiosos Yiyuan Zhang e seus colegas no Laboratório Multimídia da Universidade Chinesa de Hong Kong aumentaram o número de modalidades para uma dúzia em seu Meta-Transformador. Seus modelos de nuvens de pontos representam a visão 3D, enquanto os dados de sensoriamento hiperespectral representam a energia eletromagnética refletida de volta do solo para imagens aéreas de paisagens.

O Meta-Transformador é o futuro da inteligência artificial generativa, com toneladas de dados de diferentes tipos sendo combinados para ter uma compreensão mais completa do que está sendo produzido como resultado. É explorado no artigo de 2023, “Meta-Transformador: uma estrutura unificada para aprendizado multimodal”, de Yiyuan Zhang e colegas do Laboratório Multimídia da Universidade Chinesa de Hong Kong e do OpenGVLab no Laboratório de Inteligência Artificial de Xangai.

Criando um livro de histórias a partir de múltiplas modalidades

O benefício imediato da multimodalidade será simplesmente enriquecer a saída de algo como o ChatGPT de maneiras que vão além do modo “demonstração”. Um livro de histórias infantil, um livro com trechos de texto combinados com imagens ilustrando o texto, é um exemplo imediato. Ao combinar as características da linguagem e da imagem, os tipos de imagens criadas pelo processo de difusão podem ser controlados de forma mais sutil de imagem em imagem.

Conforme explicado por cientistas do Google e o autor principal Wan-Duo Kurt Ma, da Universidade Victoria de Wellington, na Nova Zelândia, um processo conhecido como difusão direcionada pode mover o gato – ou um castelo, ou um pássaro – por várias cenas, criando uma série de imagens que oferecem não apenas um maior controle, mas também transições como em uma narrativa.

Uma técnica chamada difusão direcionada pode mover uma entidade – um gato, um castelo, um pássaro – por várias cenas, criando uma série de imagens que oferecem não apenas um maior controle, mas também transições como em uma narrativa. É detalhada no artigo de 2023 “Difusão Direcionada: Controle Direto do Posicionamento de Objetos por Orientação da Atenção”, de Wan-Duo Kurt Ma e colegas da Universidade Victoria de Wellington e do Google Research.

Da mesma forma, Hyeonho Jeong da Universidade Sungkyunkwan da Coreia, junto com estudiosos do Instituto Avançado de Ciência e Tecnologia da Coreia, propôs uma nova abordagem para a difusão – a difusão latente – que eles detalharam em um artigo recente. Eles afirmam que isso oferece acesso a muitos mais detalhes em uma imagem em um nível baixo de granularidade.

O resultado é a capacidade de gerar livros de histórias em que um personagem se move por diferentes cenários imagem por imagem, adicionando botões de controle ao texto para selecionar diferentes cenários. A consistência do objeto em todas as imagens é o que eles chamam de “Injeção de Identidade Coerente Iterativa”.

Uma técnica chamada difusão latente estende a criação de imagens com o que seus inventores chamam de “Injeção de Identidade” para criar o movimento de um personagem através de imagens de um livro de histórias.

Assim como a síntese de proteínas no Laboratório Baker, as aplicações de multimodalidade podem se tornar bastante surpreendentes. Outro artigo recente de Chenyu Tang e colegas na Faculdade de Engenharia da Universidade de Cambridge propõe a construção de um “gêmeo digital”, uma simulação computacional do corpo humano, com todos os órgãos e tecidos renderizados, e os fluxos de sangue e similares representados, combinando dados de múltiplos instrumentos médicos no mesmo processo de difusão estável.

“Tanto sensores de movimento (como acelerômetros, sensores EMG, etc.) quanto sensores bioquímicos (para detectar biomarcadores correspondentes a doenças, como sensores de saliva, sensores de suor, etc.) podem produzir saídas específicas para o paciente,” escreveram os autores. “Embora essas saídas tenham padrões distintos, todas elas correspondem à mesma doença.”

O “gêmeo digital” do corpo humano pode ser viabilizado combinando dados de vários instrumentos médicos no mesmo processo de difusão estável. O diagrama representa o “roteiro de cinco níveis para o DT do corpo [gêmeo digital do corpo]”, conforme visto no artigo de 2023 intitulado “Plano Mestre para o Gêmeo Digital do Corpo Humano” de Chenyu Tang e colegas da Universidade de Cambridge.

Mestres modais especiais

Como as modalidades são reunidas será tão importante quanto quais, disse Mostaque da Stability.ai. “A parte final será a composição, à medida que esses blocos de construção que construímos são colocados em um software adequado que é orientado por IA, que reimagina toda essa criação, consumo e fluxos de processo com essas novas ferramentas incríveis”, disse ele.

Embora alguns modelos massivos, como o PaLM LLM ou o GPT-4 do Google, possam ser chamados, muita mistura de modalidades acontecerá como uma orquestração de componentes, disse ele. “Como você reúne modelos de maneiras realmente interessantes e tem muitos modelos diferentes trabalhando juntos para alcançar os resultados que você deseja para realmente aprimorar isso?”

Embora o PaLM e o GPT-4 possam ser poderosos, ele disse que há ampla evidência de que “muitos modelos especializados podem superar” os maiores programas. Como resultado, “Vamos ter muitos modelos especializados, eu acho, em todas as modalidades”, disse ele, um processo de “desconstrução” da tecnologia em seus papéis apropriados, “e então alguns modelos multimodais que podem fazer tudo, e eles são chamados no momento apropriado para a coisa apropriada.”

A robótica é a próxima fronteira da IA

A mistura de modalidades é notável para o campo da IA incorporada – na forma de robótica.

Sergey Levine, professor associado do departamento de engenharia elétrica da Universidade da Califórnia em Berkeley, disse ao ENBLE que, no que diz respeito à IA generativa, os sistemas em robótica desempenham um papel significativo.

“A coisa multimodal é bastante empolgante”, acrescentou Levine, membro do Berkeley Artificial Intelligence Research, da universidade, que também trabalha com equipes do Google.

Ao processar imagens e texto, uma rede neural multimodal já é capaz de produzir “comandos de alto nível para robôs”, disse ele. O código que um robótico normalmente escreveria para instruir um robô pode ser “totalmente automatizado, essencialmente”, disse Levine.

“O que queremos é a capacidade de comandar os robôs de forma rápida e fácil para fazer coisas”, disse Levine. “A ponte entre essas coisas é algo em que os modelos de linguagem serão ótimos.”

Também: O RT-2 da DeepMind torna o controle de robôs uma questão de conversa de IA

Levine ajudou a supervisionar uma demonstração inicial no Google que foi publicada recentemente, chamada PaLM-E, que os pesquisadores do Google chamam de “Modelo de Linguagem Multimodal Incorporado”. O robô é capaz de seguir uma série de instruções, como “traga-me os chips de arroz da gaveta”, que o modelo de linguagem divide em instruções atômicas, como “vá para a gaveta”, “abra a gaveta”, “pegue o pacote verde de chips de arroz”, etc.

Um trabalho subsequente, da unidade DeepMind do Google, chamado de RT-2, amplia o PaLM-E adicionando a capacidade de gerar coordenadas espaciais para o robô. Levine chama esse trabalho de “avanço significativo”.

Assim como o conceito de estereognose, Levine argumenta que o aumento das modalidades pode trazer um modelo enriquecido do mundo e, assim, trazer algumas habilidades básicas de raciocínio.

Também: O RT-2 da DeepMind torna o controle de robôs uma questão de conversa de IA

Se grandes modelos de linguagem e modelos de difusão puderem integrar o processo de “analisar imagens anteriores e prever descrições [de texto], e analisar descrições anteriores e prever imagens”, disse Levine, “agora eles podem começar, de certa forma, a aprofundar a compreensão do mundo”.

Um exemplo primitivo de conhecimento do mundo é um barman robótico em que Levine trabalhou, que verifica a identidade das pessoas. “Você pode realmente dizer ao modelo de linguagem para escrever um código para um barman robótico, e ele gera alguma lógica para fazer isso, e se alguém pede um copo de água, isso não é uma bebida alcoólica”, e, portanto, não exige uma verificação de identidade.

Vamos precisar de muita mais memória

A combinação de robótica e multimodalidade tem implicações mais profundas porque expande dramaticamente o apetite por dados. A inteligência artificial generativa de hoje, como o ChatGPT, não possui memória explícita. Ela só funciona com o último conjunto de coisas que você digitou no prompt e, depois de um tempo, esquece coisas antigas.

Usar multimodalidade que inclui muitas amostras de dados forçará a inteligência artificial generativa a desenvolver algo como uma memória real de dados. “Quando começamos a passar para modelos multimodais, isso se torna muito mais exigente em relação ao contexto”, disse Levine, “porque o protótipo atual desse modelo recebe uma imagem, mas talvez você queira fornecer mil imagens a ele.

“Talvez você queira mostrar a ele um tour pela sua casa para que ele saiba onde está tudo em sua casa, para que, quando você pedir que ele traga as chaves do carro, ele possa examinar sua memória e descobrir onde as chaves do carro estão – isso requer um contexto muito mais longo.”

Também: Microsoft, TikTok dão à inteligência artificial generativa uma espécie de memória

Dados de vídeo podem ser igualmente, se não mais, críticos para permitir que um robô construa um retrato do mundo. Esses vídeos, juntamente com texto, nuvens de pontos e outras modalidades, se tornam um simulador pelo qual um robô pode construir um modelo do mundo, disse Levine. “Se esses modelos fornecerem essencialmente uma maneira de aprender simuladores de alta fidelidade, isso poderia ter um impacto significativo no futuro.”

Expandir para milhares de imagens e possivelmente horas de vídeo, talvez gigabytes de nuvem de pontos, dados 3D, para treinar programas multimodais significa que o ChatGPT e o resto terão que expandir dramaticamente seu acesso a dados por meio de um chamado banco de memória.

Muitos esforços estão em andamento para “aumentar” os modelos de linguagem com o que é chamado de recuperação de um banco de dados. Isso pode ser visto no programa CM3Leon da Meta, que permite que o software mergulhe em um banco de dados e encontre imagens relevantes.

Esforços como a tecnologia Hyena na Universidade Stanford e o instituto MILA do Canadá tentam expandir drasticamente o que pode ser inserido no prompt de um programa, para que qualquer quantidade de dados possa ser inserida, de qualquer modalidade.

Também: Essa nova tecnologia pode superar o GPT-4 e tudo parecido com ele

Isso significa que, juntamente com a multimodalidade, os sucessores do ChatGPT poderão lidar com um contexto muito maior – livros inteiros, séries de artigos, filmes e registros de estruturas físicas em três dimensões. Também significa que o contexto para qualquer tarefa pode se tornar muito mais adaptado ao conhecimento adquirido de um indivíduo ou de um grupo. Mostaque disse que esses modelos não apenas trarão o conhecimento generalizado do GPT-4, mas também conhecimento específico, além do conhecimento da sua equipe, da sua empresa e além.

“Acho que é a grande descoberta, quando se tornar empresarial no próximo ano”, disse Mostaque, referindo-se à iminente adoção popular da inteligência artificial generativa em ambientes corporativos.

O “Sistema de Memória Autogerenciado” da ByteDance, proprietária do TikTok, pode acessar um banco de dados com centenas de rodadas de diálogo e milhares de personagens, para fornecer a qualquer modelo de linguagem capacidades superiores às do ChatGPT ao responder perguntas sobre eventos passados. Isso é mostrado no artigo de 2023, “Unleashing Infinite-Length Input Capacity for Large-scale Language Models with Self-Controlled Memory System”, de Xinnian Liang e colegas do ByteDance AI Lab.

Aprendizado contínuo alcançável

À medida que a multimodalidade se expande para vídeo, áudio, nuvens de pontos e tudo mais, Keller, CEO da empresa de chips de IA Tenstorrent, acredita que modelos generativos mais avançados, especialmente os provenientes da comunidade de software de código aberto, levarão a uma mudança profunda na distinção do campo entre treinamento e inferência.

O treinamento ocorre quando uma rede neural é desenvolvida pela primeira vez. É um processo científico extremamente custoso, com centenas ou até milhares de GPUs sendo usadas. A inferência ocorre quando a rede finalizada é usada para fazer previsões para os usuários finais, um processo muito menos exigente que é amplamente implantado como um serviço em nuvem.

Mas “os modelos generativos realmente usam várias características do treinamento na inferência”, disse Keller. Um programa como o Stable Diffusion da Stability.ai, para geração de imagens, atualiza sua rede neural durante a inferência, segundo ele. “É multipasso: tem uma passagem de retorno” além do processo típico de previsões para frente, de modo que “parece que está no modo de treinamento”.

Por essa razão, “Acredito que o mecanismo de IA do futuro… terá um conjunto de capacidades bastante diversificado que não se parecerá com inferência versus treinamento”, mas mais como uma fusão dos dois.

Se Keller estiver certo, os futuros modelos generativos poderiam ser o início de um objetivo há muito tempo almejado de aprendizado contínuo para aprendizado de máquina, também às vezes chamado de aprendizado online, em que uma rede neural generativa não está fixa uma vez treinada, mas evolui continuamente à medida que as pessoas a usam mais.

“Eu acredito que isso será o caso”, concordou Mostaque da Stability.ai. “A aprendizagem contínua será fundamental, porque a maneira como fazemos agora, ensinando [o modelo] a mesma coisa repetidamente, não é apropriada.”

Já, disse Mostaque, coisas como o “Dream Booth” da Stability.ai, que permite construir uma versão personalizada de uma imagem, estão indo além da rígida noção de retrinar um modelo de linguagem-imagem para algo mais fluido. Ele disse que esses se tornam avatares pessoais – e nos próximos meses – uma espécie de hiper-Dream Booth que permite a personalização de todas as suas imagens em tempo real.

“É por isso que a aprendizagem contínua será tão importante: para permitir esse processo contínuo de modo que ele evolua.”