Bate-papo da Nvidia com RTX uma ferramenta divertida e útil para chatbots impulsionados por IA

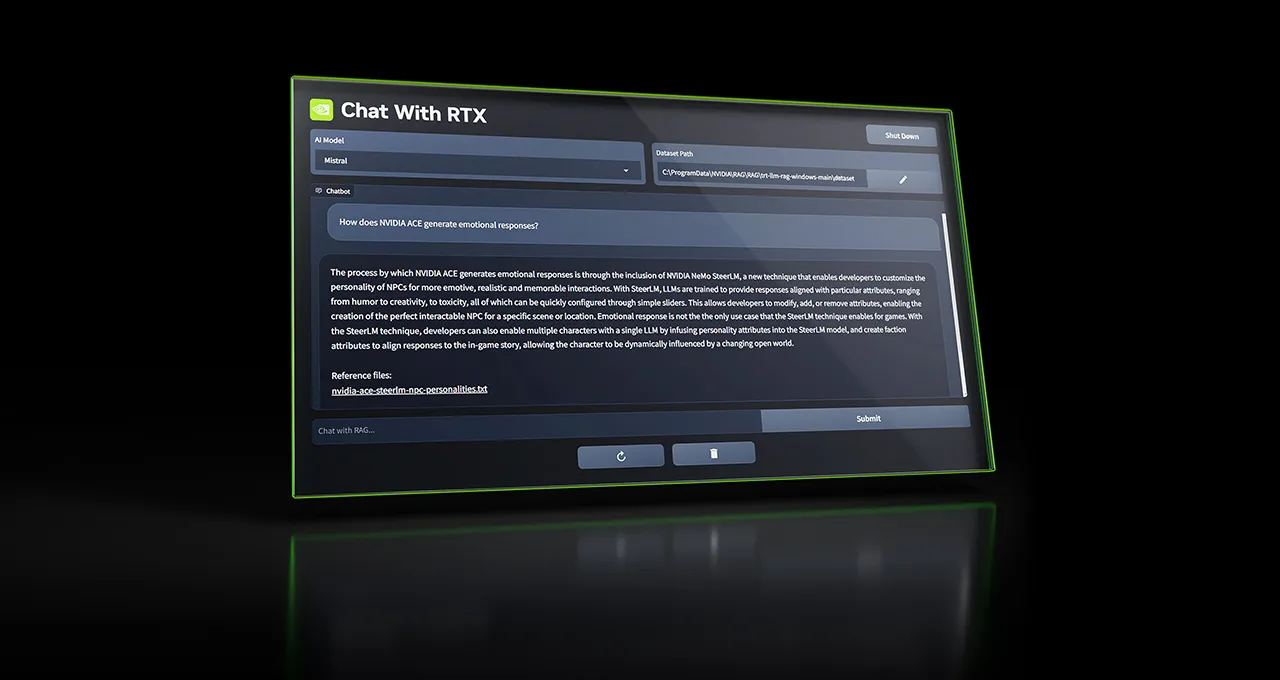

A Nvidia lançou uma nova ferramenta chamada Chat with RTX, que permite aos usuários executar um modelo GenAI offline e personalizá-lo usando seus próprios dados.

Nvidia introduziu uma nova ferramenta chamada ENBLE que permite executar modelos GenAI no seu PC.

A Nvidia, sempre ansiosa para incentivar a compra de suas últimas GPUs, está de volta com uma oferta empolgante. A gigante da tecnologia está lançando uma ferramenta chamada Chat com RTX, que permite que proprietários das placas GeForce RTX 30 Series e 40 Series executem um chatbot alimentado por IA offline em seus PCs com Windows. 🎉

Personalize e Simplifique com Chat com RTX

A beleza do Chat com RTX está em sua capacidade de permitir que os usuários personalizem um modelo GenAI, semelhante ao ChatGPT da OpenAI, e o conectem a documentos, arquivos e notas. Ao fazer isso, o chatbot pode facilmente fornecer respostas e informações ao receber consultas dos usuários. Não é mais preciso passar por pilhas de anotações ou buscar conteúdo salvo antigo!

Por exemplo, imagine que você está desesperadamente tentando lembrar o nome do restaurante que seu parceiro recomendou durante sua viagem a Las Vegas. Em vez de quebrar a cabeça ou pesquisar em arquivos intermináveis, basta digitar sua pergunta no Chat com RTX: “Qual era o restaurante que meu parceiro recomendou enquanto estávamos em Las Vegas?” O chatbot inteligente irá analisar os arquivos locais que você apontar e fornecerá a resposta, completa com contexto. Quão conveniente é isso? 😮

Opções em Abundância com Chat com RTX

O Chat com RTX vem pré-carregado com o modelo de código aberto da start-up de IA Meta. No entanto, ele também suporta outros modelos baseados em texto, incluindo o Llama 2 da Meta. Você tem a liberdade de escolher e experimentar diferentes modelos para encontrar o que melhor atende às suas necessidades.

Lembre-se, no entanto, que o download de todos os arquivos necessários pode consumir uma quantidade significativa de espaço de armazenamento. Dependendo do modelo ou modelos selecionados, você pode precisar de aproximadamente entre 50 GB e 100 GB de espaço livre. Portanto, certifique-se de ter espaço suficiente no seu PC para acomodá-los. 📁💻

- Memorizer é um aplicativo que rastreia filmes e livros e também imp...

- 🤖 Bots de IA no telefone? Cambio está revolucionando o mundo bancár...

- Mindy Sua Assistente Executiva Baseada em E-mail 📧💼

Um Chatbot Multifuncional

O Chat com RTX atualmente funciona com vários formatos de arquivo, como texto, PDF, .doc, .docx e .xml. Ao apontar o aplicativo para uma pasta contendo esses arquivos suportados, você pode fazer com que eles sejam carregados no conjunto de dados de ajuste fino do modelo. E isso não é tudo! Se você fornecer a URL de uma playlist do YouTube, o chatbot até mesmo carregará transcrições dos vídeos na playlist. Esse recurso permite que você faça consultas sobre o conteúdo dos vídeos usando o modelo selecionado. Fale sobre versatilidade! 📚📽️📑

Limitações e Espaço para Melhorias

A Nvidia deseja estabelecer expectativas realistas para os usuários do Chat com RTX. O aplicativo possui algumas limitações que você deve ter em mente. Em primeiro lugar, o chatbot não consegue se lembrar do contexto. Isso significa que ele não levará em consideração perguntas anteriores ao responder a consultas adicionais. Por exemplo, se você perguntar “Qual é um pássaro comum na América do Norte?” e em seguida perguntar “Quais são suas cores?”, o Chat com RTX não conseguirá conectar as duas perguntas e entender que você está se referindo a pássaros. É uma pequena desvantagem em uma ferramenta incrível. 🤷♂️

A Nvidia também reconhece que a relevância das respostas do chatbot pode ser afetada por vários fatores. Isso inclui a forma como as perguntas são formuladas, o desempenho do modelo selecionado e o tamanho do conjunto de dados de ajuste fino. Fazer perguntas sobre informações contidas em documentos específicos geralmente resulta em melhores resultados do que solicitar um resumo desses documentos. Além disso, a qualidade das respostas tende a melhorar com conjuntos de dados maiores. Portanto, se você deseja que o Chat com RTX forneça respostas precisas e detalhadas, garanta que você tenha um conjunto de dados robusto sobre o assunto relevante. 📊📈📖

Vale mencionar que o Chat com RTX é mais um brinquedo divertido e útil do que uma ferramenta para uso em produção. No entanto, ferramentas como essa contribuem para uma tendência crescente de tornar os modelos de IA mais acessíveis e utilizáveis localmente. O Fórum Econômico Mundial prevê um “aumento dramático” de dispositivos acessíveis capazes de executar modelos GenAI offline. Isso inclui dispositivos como PCs, smartphones, dispositivos de Internet das Coisas (IoT) e equipamentos de rede. Esses modelos offline oferecem vantagens claras. Eles são inherentemente mais privados, visto que os dados que processam nunca saem do dispositivo em que estão sendo executados. Além disso, eles possuem menor latência e são mais econômicos em comparação com os modelos hospedados em nuvem. 🌍💪💻

O Futuro dos Modelos de IA: Equilibrando Benefícios e Riscos

É claro que democratizar ferramentas para executar e treinar modelos levanta preocupações sobre possíveis abusos. Com uma rápida pesquisa no Google, você encontrará muitos modelos que foram ajustados para conteúdo tóxico de cantos inescrupulosos da web. No entanto, defensores argumentam que as vantagens de aplicativos como Chat com RTX superam os riscos. Como qualquer avanço tecnológico, é uma questão de encontrar o equilíbrio certo. Somente o tempo dirá como essa tendência se desenrolará e quais medidas serão tomadas para mitigar riscos potenciais. 👀⚖️

No geral, Chat com RTX é uma adição emocionante à linha de ferramentas da Nvidia. Ele traz o poder dos chatbots de IA para a ponta dos dedos, permitindo personalização e facilidade de uso. Embora possa ter suas limitações, é um passo na direção certa para tornar a IA mais acessível e disponível offline. Então, independentemente de você ser um entusiasta da tecnologia ou apenas alguém procurando uma ferramenta útil, Chat com RTX definitivamente vale a pena experimentar! 💬💡

P&R

P: O Chat com RTX se lembra do contexto?

R: Infelizmente, o aplicativo não se lembra do contexto. Isso significa que ele não levará em conta quaisquer perguntas anteriores ao responder a consultas de acompanhamento. Cada pergunta é tratada de forma independente.

P: Que tipos de arquivos o Chat com RTX suporta?

R: O Chat com RTX funciona atualmente com formatos de arquivos de texto, PDF, .doc, .docx e .xml. Assim, você pode carregar facilmente esses tipos de arquivos no conjunto de dados de ajuste fino do chatbot e consultá-los para obter informações.

P: O desempenho do modelo selecionado afeta a relevância das respostas do chatbot?

R: Sim, o desempenho do modelo selecionado desempenha um papel na relevância das respostas do chatbot. No entanto, outros fatores, como a formulação das perguntas e o tamanho do conjunto de dados de ajuste fino, também contribuem para a precisão e utilidade das respostas fornecidas pelo Chat com RTX.

P: Quanto espaço de armazenamento eu preciso para o Chat com RTX?

R: A quantidade de espaço de armazenamento necessário para o Chat com RTX depende do(s) modelo(s) que você escolher. Pode variar de 50GB a 100GB. Verifique se você tem espaço livre suficiente em seu PC para acomodar os arquivos necessários.

De Olho no Futuro

Com o surgimento de ferramentas como o Chat com RTX, o futuro dos modelos de IA executando offline parece promissor. O Fórum Econômico Mundial prevê um aumento significativo de dispositivos acessíveis capazes de lidar com modelos GenAI offline. Essa mudança traz uma série de vantagens, desde maior privacidade até menor latência e custo-efetividade. À medida que a tecnologia continua a evoluir, provavelmente veremos mais avanços em modelos de IA offline e suas aplicações em diversos dispositivos e setores. Tempos emocionantes estão por vir! 🚀🌌

Referências: – Pesquisadores desbloquearam o ChatGPT – Kusari construindo plataforma de segurança da cadeia de suprimentos (Top Open Source) – Llama 2