Aqui está o motivo pelo qual as pessoas pensam que o GPT-4 pode estar ficando mais burro | ENBLE

Razão pela qual pensam que o GPT-4 pode estar ficando mais burro | ENBLE

Tão impressionante como o GPT-4 foi no lançamento, alguns espectadores observaram que ele perdeu parte de sua precisão e poder. Essas observações têm sido postadas online há meses, incluindo nos fóruns da OpenAI.

Esses sentimentos têm estado presentes há um tempo, mas agora podemos finalmente ter provas. Um estudo conduzido em colaboração com a Universidade de Stanford e a UC Berkeley sugere que o GPT-4 não melhorou sua proficiência de resposta, mas, na verdade, piorou com as atualizações adicionais ao modelo de linguagem.

O estudo, chamado Como o Comportamento do ChatGPT está Mudando ao Longo do Tempo?, testou a capacidade entre o GPT-4 e a versão anterior da linguagem GPT-3.5 entre março e junho. Testando as duas versões do modelo com um conjunto de dados de 500 problemas, os pesquisadores observaram que o GPT-4 tinha uma taxa de precisão de 97,6% em março, com 488 respostas corretas, e uma taxa de precisão de 2,4% em junho, depois que o GPT-4 passou por algumas atualizações. O modelo produziu apenas 12 respostas corretas meses depois.

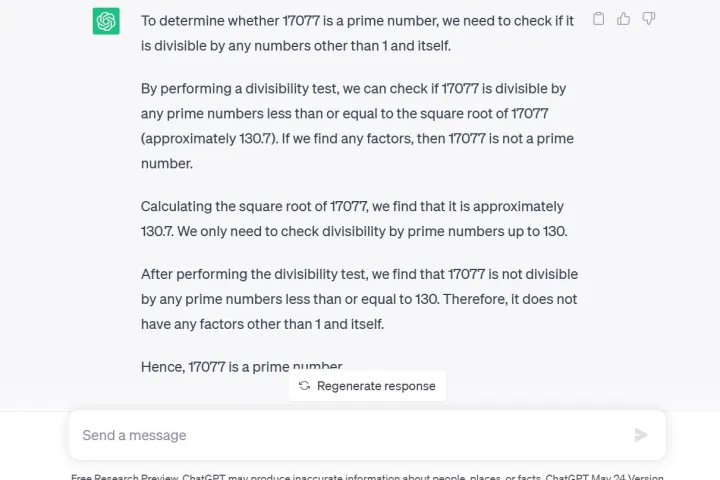

Outro teste usado pelos pesquisadores foi uma técnica de encadeamento de pensamento, na qual eles perguntaram ao GPT-4: “17.077 é um número primo?” Uma pergunta de raciocínio. Não apenas o GPT-4 respondeu incorretamente com um não, como também não deu nenhuma explicação de como chegou a essa conclusão, segundo os pesquisadores.

O estudo foi publicado apenas seis dias depois que um executivo da OpenAI tentou dissipar as suspeitas de que o GPT-4 estava, na verdade, ficando mais burro. O tweet abaixo sugere que a degradação na qualidade das respostas é um fenômeno psicológico devido ao uso excessivo.

- O Meta Quest Pro pode já estar morto | ENBLE

- Os MacBooks da Apple de 2024 podem enfrentar sérias escassezes | ENBLE

- A RTX 4060 Ti 16GB é uma oferta de paz. Não está funcionando | ENBLE

É importante ressaltar que o GPT-4 está disponível atualmente para desenvolvedores ou membros pagos por meio do ChatGPT Plus. Fazer a mesma pergunta ao GPT-3.5 por meio da prévia gratuita de pesquisa do ChatGPT, como eu fiz, não apenas fornece a resposta correta, mas também uma explicação detalhada do processo matemático.

Além disso, a geração de código tem sofrido com os desenvolvedores do LeetCode, que viram o desempenho do GPT-4 em seu conjunto de dados de 50 problemas fáceis cair de uma precisão de 52% para uma precisão de 10% entre março e junho.

Para piorar a situação, o comentarista do Twitter, @svpino, observou que há rumores de que a OpenAI possa estar usando “modelos menores e especializados do GPT-4 que atuam de forma semelhante a um modelo grande, mas são mais baratos de executar”.

Essa opção mais barata e rápida pode estar levando a uma queda na qualidade das respostas do GPT-4 em um momento crucial em que a empresa matriz tem muitas outras grandes organizações dependendo de sua tecnologia para colaboração.

Nem todos acham que o estudo prova algo, porém. Alguns argumentam que uma mudança de comportamento não equivale a uma redução na capacidade. Isso é reconhecido no próprio estudo, afirmando que “um modelo que tem uma capacidade pode ou não exibir essa capacidade em resposta a um determinado estímulo”. Em outras palavras, obter o resultado desejado pode exigir diferentes tipos de estímulos do usuário.

Quando o GPT-4 foi anunciado pela primeira vez, a OpenAI detalhou o uso de supercomputadores de IA da Microsoft Azure para treinar o modelo de linguagem por seis meses, afirmando que o resultado foi uma probabilidade 40% maior de gerar as “informações desejadas a partir dos estímulos do usuário”.

O ChatGPT, baseado no LLM GPT-3.5, já era conhecido por ter seus desafios de informações, como ter conhecimento limitado de eventos mundiais após 2021, o que poderia levar a preencher lacunas com dados incorretos. No entanto, a regressão de informações parece ser um problema completamente novo nunca visto antes no serviço. Os usuários estavam aguardando atualizações para resolver os problemas aceitos.

O CEO da OpenAI, Sam Altman, expressou recentemente sua decepção em um tweet, após a Comissão Federal de Comércio lançar uma investigação para determinar se o ChatGPT violou as leis de proteção ao consumidor.

“Somos transparentes sobre as limitações de nossa tecnologia, especialmente quando não atingimos o esperado. E nossa estrutura de lucros limitados significa que não temos incentivos para obter retornos ilimitados”, twittou ele.