A onda de visão múltipla da IA está chegando e será poderosa

The wave of AI's multiple vision is coming and will be powerful.

A chamada multi-visão é uma forma de vincular dois sinais diferentes considerando as informações que eles compartilham sobre o mesmo objeto, apesar das diferenças. A multi-visão pode abrir um caminho para máquinas que podem ter uma compreensão mais rica da estrutura do mundo, talvez contribuindo para o objetivo de máquinas que podem “raciocinar” e “planejar”.

A inteligência artificial em sua forma mais bem-sucedida – coisas como o ChatGPT ou o AlphaFold da DeepMind para prever proteínas – tem sido limitada a uma dimensão conspicuamente estreita: a IA vê as coisas de apenas um lado, como uma palavra, como uma imagem, como uma coordenada no espaço – como qualquer tipo de dado, mas apenas um de cada vez.

Em muito pouco tempo, as redes neurais estão prestes a expandir drasticamente com uma fusão de formas de dados que irão olhar para a vida de muitos ângulos. É um desenvolvimento importante, pois pode dar às redes neurais uma base maior nas formas pelas quais o mundo se coesa, nas formas pelas quais as coisas se mantêm juntas, o que pode ser uma etapa importante no movimento em direção a programas que possam um dia executar o que você chamaria de “raciocínio” e “planejamento” sobre o mundo.

Também: Meta revela tradutor de fala para fala ‘Seamless’

A próxima onda de dados de múltiplos lados tem suas raízes em anos de estudo por cientistas de aprendizado de máquina e geralmente é conhecida como “multi-visão” ou, alternativamente, fusão de dados. Há até mesmo um periódico acadêmico dedicado ao tema, chamado Information Fusion, publicado pela gigante editorial acadêmica Elsevier.

- Melhores smartwatches Apple Watch, Samsung Galaxy Watch, Garmin Ven...

- Doze nações pedem que as gigantes das redes sociais combatam a cole...

- Um kit de carro Roadmaster Bluetooth Hands-Free gratuito vai para o...

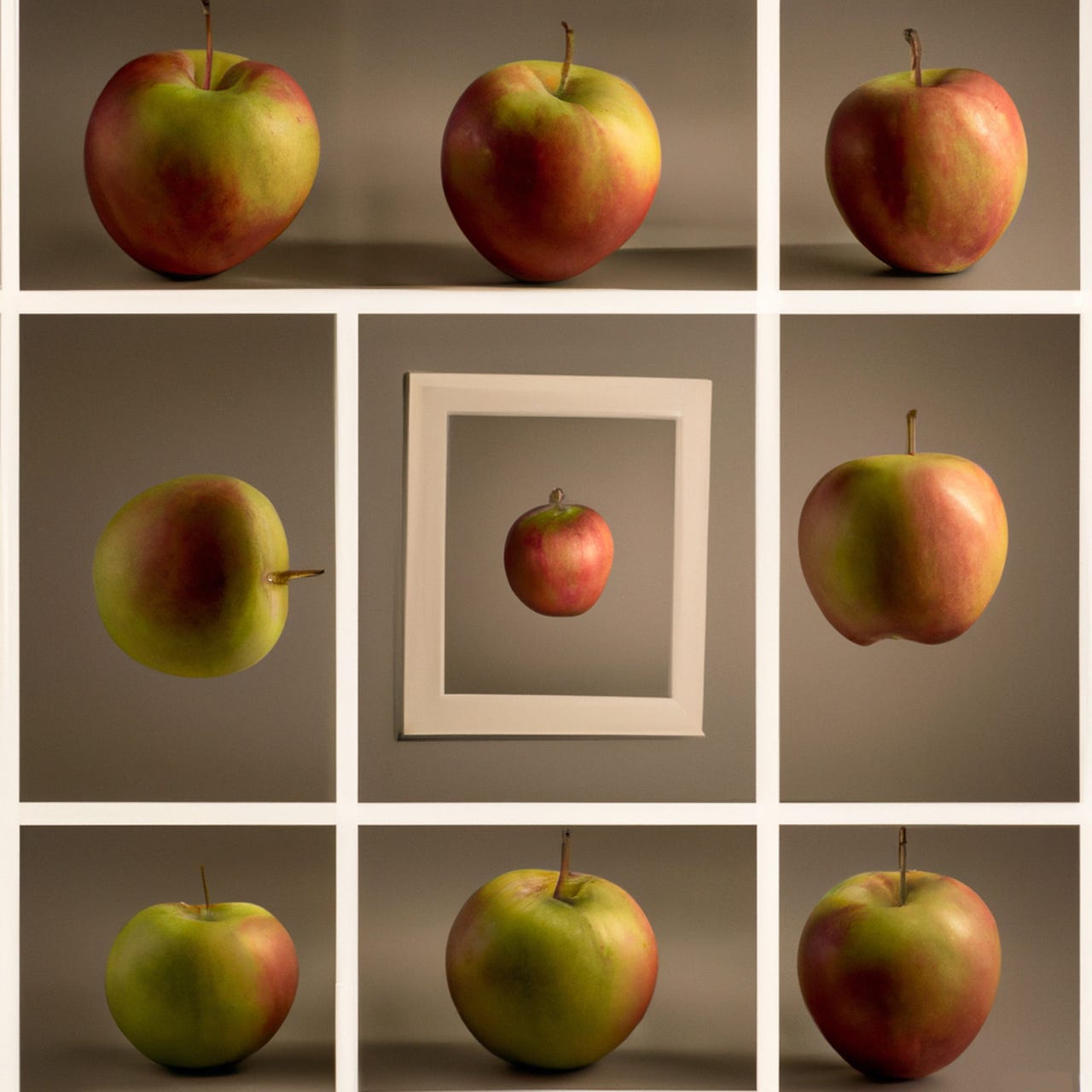

A ideia fundamental da fusão de dados é que qualquer coisa no mundo que se esteja tentando examinar tem muitos lados ao mesmo tempo. Uma página da web, por exemplo, possui tanto o texto que você vê a olho nu quanto o texto âncora que vincula a essa página, ou até mesmo uma terceira coisa, o código HTML e CSS subjacente que é a estrutura da página.

Uma imagem de uma pessoa pode ter tanto um rótulo com o nome da pessoa quanto os pixels da imagem. Um vídeo tem um quadro de vídeo, mas também o clipe de áudio que acompanha esse quadro.

Os programas de IA atuais tratam esses dados variados como peças separadas de informações sobre o mundo, com pouca ou nenhuma conexão entre eles. Mesmo quando as redes neurais lidam com vários tipos de dados, como texto e áudio, na maioria das vezes eles apenas processam esses conjuntos de dados simultaneamente – eles não vinculam explicitamente vários tipos de dados com a compreensão de que são visões do mesmo objeto.

Por exemplo, a Meta Properties – proprietária do Facebook, Instagram e WhatsApp – revelou na terça-feira seu mais recente esforço em tradução automática, um tour de force no uso de múltiplas modalidades de dados. O programa, SeamlessM4T, é treinado tanto em dados de fala quanto em dados de texto ao mesmo tempo e pode gerar tanto texto quanto áudio para qualquer tarefa.

Mas o SeamlessM4T não percebe cada unidade de cada sinal como uma faceta do mesmo objeto.

Também: O gerador de imagens de IA da Meta diz que a linguagem pode ser tudo o que você precisa

Essa visão fragmentada das coisas está começando a mudar. Em um artigo publicado recentemente pela professora assistente da Universidade de Nova York e pesquisadora do corpo docente Ravid Shwartz-Ziv, e o cientista-chefe de IA da Meta, Yann LeCun, a dupla discute o objetivo de usar a multi-visão para enriquecer as redes neurais de aprendizado profundo, representando objetos de múltiplas perspectivas.

Os objetos são fragmentados em sinais não relacionados nas redes neurais profundas de hoje. A próxima onda de multi-modalidade, empregando imagens mais sons mais texto mais nuvens de pontos, redes gráficas e muitos outros tipos de sinais, pode começar a juntar um modelo mais rico da estrutura das coisas.

No artigo altamente técnico e bastante teórico, publicado no servidor de pré-impressão arXiv em abril, Shwartz-Ziv e LeCun escrevem que “o sucesso do aprendizado profundo em diversos domínios de aplicação tem levado a um interesse crescente em métodos de multi-visão profunda, que têm demonstrado resultados promissores.”

A multi-visão está caminhando para um momento de destino, à medida que as redes neurais cada vez maiores de hoje – como o SeamlessM4T – assumem cada vez mais modalidades, conhecidas como IA “multi-modal”.

Também: Os melhores chatbots de IA de 2023: ChatGPT e alternativas

O futuro da chamada IA generativa, programas como ChatGPT e Stable Diffusion, combinará uma infinidade de modalidades em um único programa, incluindo não apenas texto, imagens e vídeo, mas também nuvens de pontos e grafos de conhecimento, até mesmo dados de bioinformática e muitas outras visualizações de uma cena ou de um objeto.

As muitas modalidades diferentes oferecem potencialmente milhares de “visualizações” das coisas, visualizações que podem conter informações mútuas, o que pode ser uma abordagem muito rica para entender o mundo. Mas também apresenta desafios.

A chave para a multi-visão em redes neurais profundas é um conceito que Shwartz-Ziv e outros têm hipotetizado conhecido como um “gargalo de informação”. O gargalo de informação se torna problemático à medida que o número de modalidades se expande.

Um gargalo de informação é um conceito-chave em aprendizado de máquina. Nas camadas ocultas de uma rede profunda, a ideia é que a entrada da rede seja reduzida às coisas mais essenciais para produzir uma reconstrução da entrada, uma forma de compressão e descompressão.

Em um gargalo de informação, várias entradas são combinadas em uma “representação” que extrai os detalhes relevantes compartilhados pelas entradas como visualizações diferentes do mesmo objeto. Em uma segunda etapa, essa representação é então reduzida a uma forma comprimida que contém apenas os elementos essenciais da entrada necessários para prever uma saída que corresponda a esse objeto. Esse processo de acumular informações mútuas e, em seguida, remover ou comprimir tudo, exceto o essencial, é o gargalo de informação.

O desafio para a multi-visão em grandes redes multimodais é saber quais informações de todas as visualizações diferentes são essenciais para as muitas tarefas que uma rede neural gigante executará com todas essas modalidades diferentes.

Também: Você pode criar seu próprio chatbot de IA com esta ferramenta de arrastar e soltar

Como exemplo simples, uma rede neural que realiza uma tarefa baseada em texto, como o ChatGPT, produzindo frases de texto, pode ter problemas quando também precisa, por exemplo, produzir imagens, se os detalhes relevantes para a última tarefa foram descartados durante a etapa de compressão.

Como Shwartz-Ziv e LeCun escrevem: “[S]eparar informações em componentes relevantes e irrelevantes se torna desafiador, muitas vezes levando a um desempenho subótimo.”

Ainda não há uma resposta clara para esse problema, declaram os estudiosos. Isso exigirá mais pesquisas; em particular, redefinir a multi-visão de algo que inclui apenas duas visualizações diferentes de um objeto para possivelmente muitas visualizações.

“Para garantir a otimalidade desse objetivo, devemos expandir a suposição de multi-visão para incluir mais do que duas visualizações”, escrevem eles. Em particular, a abordagem tradicional de multi-visão assume “que informações relevantes são compartilhadas entre todas as visualizações e tarefas diferentes, o que pode ser excessivamente restritivo”, acrescentam. Pode ser que as visualizações compartilhem apenas algumas informações em alguns contextos.

Também: É assim que a IA generativa vai melhorar a economia de gig

“Como resultado”, concluem, “definir e analisar uma versão mais refinada dessa solução ingênua é essencial.”

Sem dúvida, o surgimento da multimodalidade impulsionará a ciência da multi-visão a desenvolver novas soluções. A explosão da multimodalidade na prática levará a novas descobertas teóricas para a IA.